Bereits 2009 hat das SENSEable City Lab des Massachusetts Institute of Technology (MIT) in Zusammenarbeit mit dem Volkswagen Electronic Research Lab AIDA 1.0, den Affective, Intelligent Driving Agent (kurz: AIDA), vorgestellt.

Bereits die erste Version konnte die Umgebung – sowohl inner- als auch außerhalb des Wagens – wahrnehmen. So konnte AIDA erkennen ob sich das Fahrzeug gerade auf einer Autobahn, in einem Wohngebiet oder in einem Industriegebiet befindet. Sensoren im Auto erfassen die Sitzposition, den Reifendruck, Tankstand oder den Abstand zum Vordermann. Außerdem konnte AIDA sich häufig gefahrene Strecken wie den Weg von der Wohnung zur Arbeit oder zum Supermarkt merken und bereits im Vorfeld Informationen über die Verkehrslage geben. Die Routenplanung wurde dabei so angepasst, dass AIDA selbständig entschied ob es derzeit sinnvoller ist zu Supermarkt A oder B zu fahren.

Durch das niedliche Design, das ein wenig an E.T. oder Wall-E erinnerte, sollte die Distanz zwischen Fahrer und Navigationsgerät verringert werden. Ziel ist es, die Navigationslösung die gleiche Wirkung entfalten zu lassen wie ein informierter und freundlicher Beifahrer.

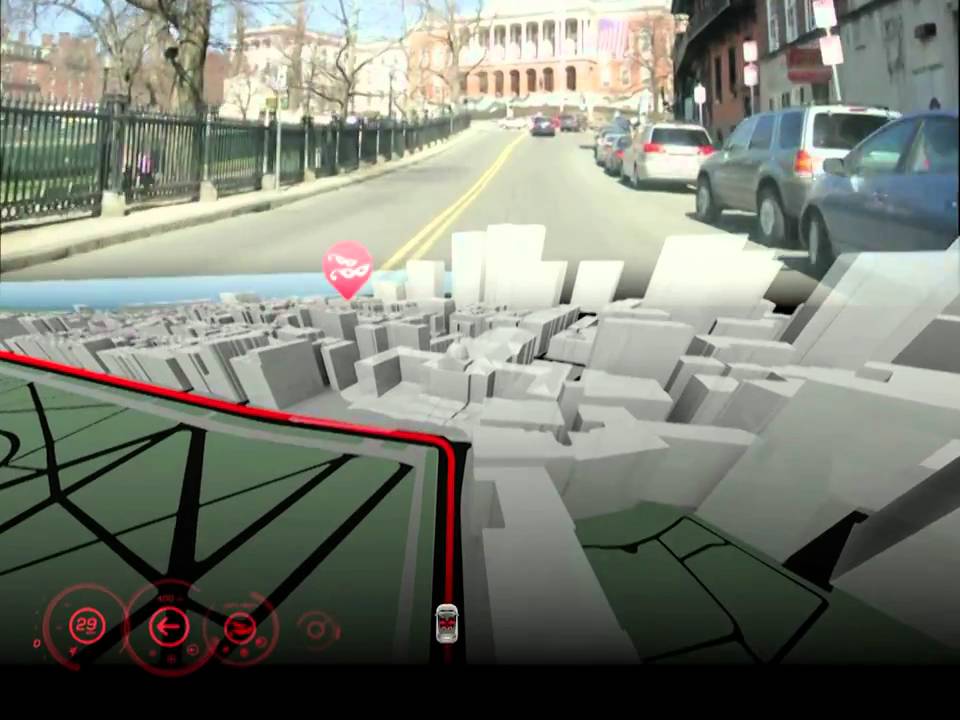

AIDA 2.0 ist eine Weiterentwicklung von AIDA. Die neue Version ist der alten vom Konzept her ähnlich, geändert hat sich allerdings das Interface. Statt mit einem Roboter zu kommunizieren, wird die Navigationslösung als 3D-Hologramm in das Armaturenbrett projiziert.

Und neben der Navigation kann AIDA 2.0 auch andere Funktionen des Fahrzeugs wie Klimaanlage, Radio, etc. steuern. Gesteuert wird mit Gesten und mit einem “Fingerzeit” auf ein interessantes Objekt.

Ich persönlich fürchte allerdings, dass AIDA 2.0 den Fahrer vom Wesentlichen ablenken könnte: der Straße

Die Navigationslösung als auch der mögliche Ablenkungsfaktor lässt sich eindrucksvoll in diesem Video nachvollziehen: